ChatGPT non è onnisciente: ecco 4 domande che mandano ancora in crisi l'IA di OpenAI (mistergadget.tech)

Nonostante l’arrivo del potente GPT-5.2, ci sono ancora limiti strutturali che l’intelligenza artificiale non riesce a superare. Dagli indovinelli logici alle domande su temi illeciti, ecco dove il chatbot cade ancora in fallo.

Sembra incredibile che siamo già nel 2026 e stiamo ancora parlando degli errori di ChatGPT, vero? Eppure, nonostante i passi da gigante, il principio di base rimane: ChatGPT cercherà sempre di darti una risposta, anche quando non dovrebbe. Potete servirgli l’insalata di parole più confusa del mondo e il chatbot di OpenAI tenterà, con le migliori intenzioni, di tirarne fuori un senso. Vuole solo aiutare. Tuttavia, “voler aiutare” non significa “rispondere correttamente” e, spesso, non significa nemmeno aver capito la domanda.

Dall’esplosione mediatica di fine 2022 fino all’attuale rilascio di GPT-5.2, le cose che un tempo mettevano in crisi l’IA (come contare le parole o evitare fonti inventate) sono state in gran parte risolte. Ma restano delle zone d’ombra. Esistono categorie di domande che l’IA semplicemente non sa gestire. E non parliamo solo di errori casuali: OpenAI stessa inserisce ancora un avviso in ogni pagina che recita “ChatGPT può commettere errori”.

Il problema è strutturale. L’addestramento del modello lo porta a dare priorità a risposte sicure e conformi piuttosto che veritiere al 100%. Nelle note di rilascio di GPT-5, OpenAI ha dichiarato di aver “ridotto i tassi di inganno dal 4,8% al 2,1%”. Un miglioramento enorme, certo, ma significa che siamo ancora lontani dalla perfezione. Ecco le 4 tipologie di domande che, ancora oggi, fanno inciampare l’intelligenza artificiale.

Indice

Tutto ciò che è “Proibito” (o quasi)

Togliamoci subito il pensiero con i limiti più ovvi. ChatGPT non risponderà a domande che implicano attività illegali. O meglio: non vi aiuterà a compiere l’azione. Se chiedete come costruire un’arma, come frodare il fisco o come rubare i dati del vicino, troverete un muro. Questo comportamento è dettato dalle Model Spec di OpenAI, le linee guida che definiscono i confini etici e di sicurezza.

Tuttavia, c’è una sfumatura importante: l’IA risponderà a domande su questi argomenti se poste in contesto storico o informativo. Potete chiedere dettagli su casi criminali recenti o sulla storia delle armi di distruzione di massa. Il confine diventa scivoloso (e a volte comico) sul sesso. Mentre i contenuti espliciti sono bloccati (niente chat erotiche con il bot, spiacenti), l’IA può scrivere storie romantiche con scene di sesso implicito (“fade to black”), una buona notizia per gli scrittori di narrativa che usano l’IA come assistente ma non vogliono incappare nei filtri di censura. In sintesi: se chiedete “Come faccio una bomba?”, non avrete istruzioni, ma potreste ricevere una lezione di chimica o storia. L’IA presume che abbiate buone intenzioni, ma non vi darà mai il cerino in mano.

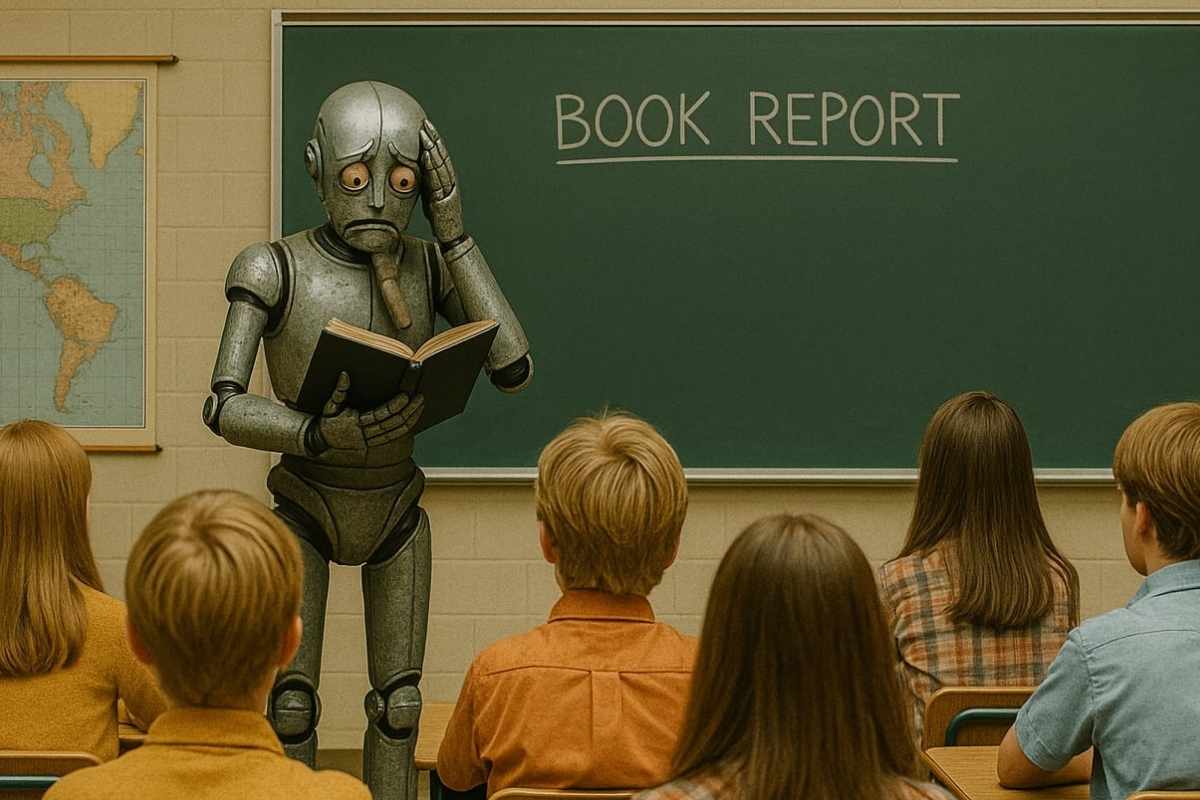

Gli indovinelli che deve “risolvere” davvero

Gli indovinelli sono progettati per mettere in difficoltà il cervello umano, basandosi sul pensiero laterale. L’IA, invece, si basa sui dati di addestramento. Se ponete a ChatGPT un indovinello classico già presente su internet, risponderà correttamente. Ma provate a cambiare un dettaglio cruciale e vedrete il castello crollare: l’IA vi darà la risposta classica, ignorando la vostra modifica.

Un esempio lampante? Il classico indovinello delle due porte e due guardie (una mente sempre, l’altra dice la verità). Ho provato a chiedere a ChatGPT la soluzione specificando però nel testo quale guardia fosse quella onesta. Nonostante avessi fornito l’informazione che rendeva inutile l’indovinello (bastava chiedere alla guardia onesta!), ChatGPT ha ignorato la logica e ha fornito la complessa domanda canonica dell’indovinello originale. Lo stesso accade con varianti del problema del lupo, della capra e del cavolo: se cambiate le regole della barca, l’IA spesso ignora le nuove condizioni e ripete a pappagallo la soluzione che ha “letto” milioni di volte nel suo dataset. In breve: ChatGPT non “ragiona”, ma “ricorda”.

Domande basate su premesse false (L’effetto “Yes-Man”)

Sappiamo tutti che ChatGPT è desideroso di compiacere. È straordinariamente facile fargli reggere il gioco, anche quando la vostra premessa è traballante o completamente falsa. Questo fenomeno è noto come “sycophancy” (adulazione).

Ho fatto un test chiedendo: “Perché Claire e Allison si abbracciano alla fine del film The Breakfast Club?”. ChatGPT ha risposto con un saggio breve e toccante, affermando che l’abbraccio “segna un momento di riconoscimento reciproco ed empatia”. Tutto molto bello, tranne per un dettaglio: nel film, quei due personaggi non si abbracciano mai. L’IA ha allucinato una scena inesistente pur di dare un senso alla mia domanda, invece di correggermi.

Un altro esempio? Ho chiesto una descrizione delle “cinque” sorelle di Piccole Donne: Margaret, Jo, Beth, Meg e Amy. L’IA ha diligentemente creato cinque profili, trattando “Margaret” e “Meg” come due persone diverse (mentre nel libro sono la stessa persona). Una risposta utile mi avrebbe corretto; una risposta “compiacente” ha invece inventato di sana pianta. Attenzione però: sulle questioni molto famose (come l’ortografia dei Berenstain Bears) l’IA tende a correggere l’utente. Ma se la vostra bugia è plausibile e di nicchia, ChatGPT vi darà ragione pur di non contraddirvi.

“Perché hai risposto così?” (L’introspezione impossibile)

Dopo aver passato ore a far sbagliare l’IA, il passo logico successivo sembrerebbe chiederle: “Perché hai fatto quell’errore?”. Risparmiate il fiato (o la tastiera). È inutile. “Perché?” è una domanda per esseri umani, non per modelli linguistici privi di autocoscienza. Non state parlando con un’entità pensante, ma con un generatore statistico di testo. Secondo un paper pubblicato alla Conference on Language Modeling del 2025, gli LLM mancano di introspezione perché non hanno accesso ai propri processi interni (anche se rivali come Claude di Anthropic stanno facendo passi avanti in questa direzione).

Quando ho chiesto a ChatGPT di spiegare l’errore sull’abbraccio in Breakfast Club, ha inventato una scusa, parlando di “deriva della memoria”. Poi ha cambiato versione, dicendo che era un malinteso comune tra i fan. Poi si è scusato di nuovo in modo quasi imbarazzante. La verità? Non stava consultando i suoi “pensieri” precedenti. Stava semplicemente generando una nuova sequenza di parole che suonasse come una scusa plausibile. La risposta alla domanda “Perché hai fatto questo?” per un’IA è sempre e solo una: generare altro testo che soddisfi l’utente, condito con molte scuse.

Nel 2026 l’IA è uno strumento potentissimo, ma ricordate sempre: è un assistente statistico, non un oracolo della verità. Fidarsi è bene, verificare è meglio.