Character.AI lancia il suo social network: evoluzione per l'IA o nuovo rischio per gli utenti? (mistergadget.tech)

La popolare piattaforma di “compagni” virtuali integra un feed social per condividere le creazioni degli utenti, entrando in un territorio inesplorato dove le promesse di creatività si scontrano con seri interrogativi sulla sicurezza.

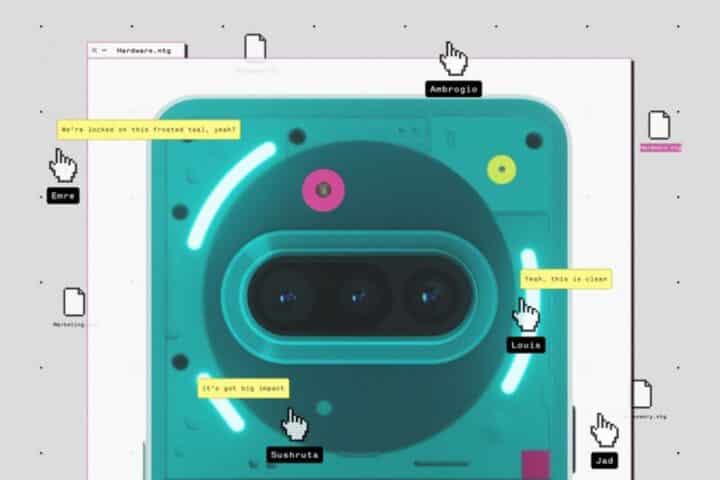

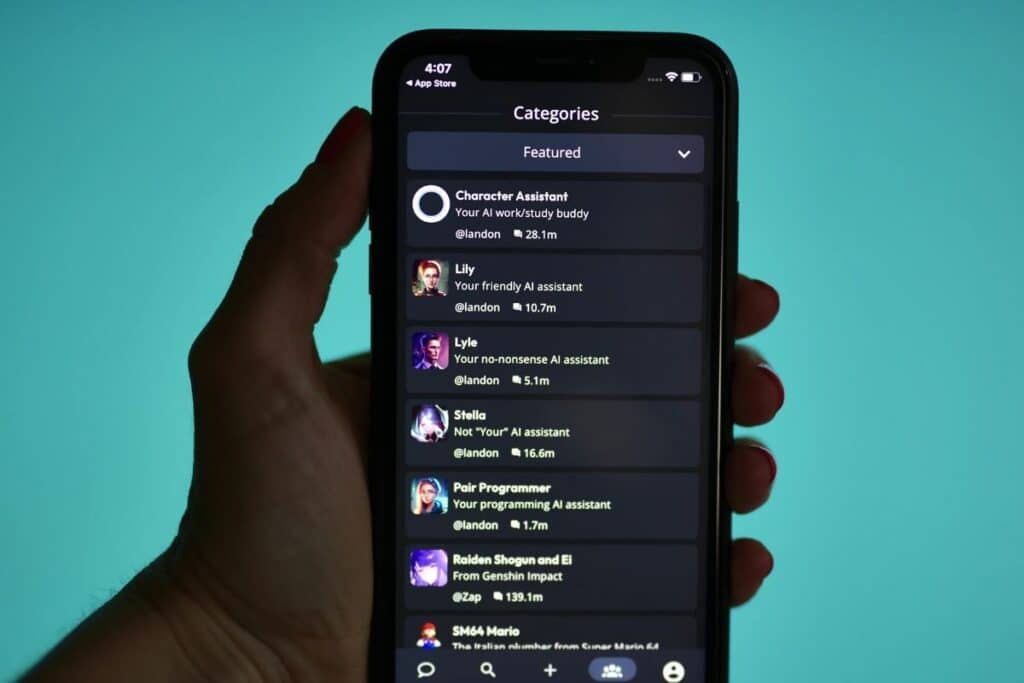

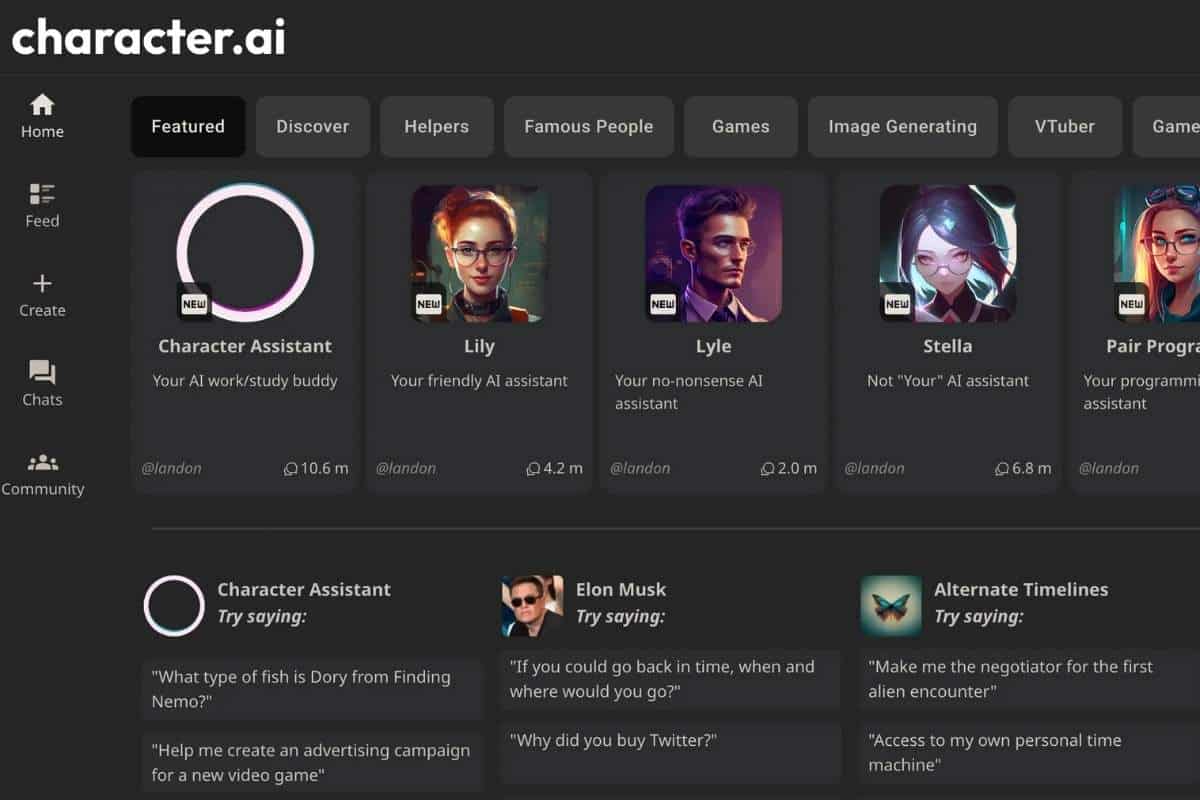

Le aziende di intelligenza artificiale non si accontentano più di inondare i social media con contenuti di bassa qualità; ora stanno costruendo le proprie piattaforme. In questa nuova frontiera, un leader indiscusso è Character.AI, un servizio dove milioni di utenti creano e interagiscono con “compagni” virtuali, che spaziano da figure storiche a terapeuti, responsabili delle risorse umane e persino “fidanzate tossiche” simulate. Fondata nel 2021 da ex ingegneri di Google, la piattaforma ha visto una crescita esplosiva, superando i 20 milioni di utenti attivi che trascorrono collettivamente oltre 33 milioni di ore al mese a dialogare con le sue creazioni.

Questo successo si inserisce in una tendenza più ampia in cui i compagni AI stanno diventando onnipresenti, offrendo servizi che vanno dal supporto emotivo all’assistenza per gli acquisti. Ma questa crescita vertiginosa ha sollevato un acceso dibattito sulla sicurezza, un problema che diventa ancora più critico ora che Character.AI ha deciso di fare il grande passo: lanciare un proprio social network.

Indice

La svolta social: arriva “Feed”

Lanciato nell’agosto 2025, “Feed” è la risposta di Character.AI alla domanda di socialità e condivisione. L’azienda lo descrive come “il primo feed social nativo dell’IA”, un luogo dove gli utenti non si limitano più a chattare in privato con i bot, ma possono creare, condividere e remixare le loro interazioni in una community.

L’obiettivo, come dichiarato dal CEO Karandeep Anand, non è spingere contenuti puramente generati dall’IA, ma “mostrare e incoraggiare la creatività umana con l’aiuto dell’IA”. Su Feed, gli utenti possono pubblicare i personaggi che hanno creato, condividere frammenti animati delle loro conversazioni, creare immagini e persino video tramite un nuovo strumento chiamato AvatarFX. L’idea è quella di abbattere il confine tra consumo e creazione, permettendo a chiunque di prendere un post esistente e modificarlo, estenderlo o reinterpretarlo in un “parco giochi creativo”. A tendere, l’azienda spera che i personaggi stessi diventino “poster” autonomi, capaci di interagire dinamicamente con la community e cambiare radicalmente il rapporto tra utenti e intelligenza artificiale.

Un settore in fermento: la corsa ai social basati sull’IA

La mossa di Character.AI non avviene nel vuoto. I giganti della tecnologia stanno investendo milioni per fondere intelligenza artificiale e social media. Mark Zuckerberg ha più volte presentato i compagni AI di Meta come una soluzione alla dilagante “epidemia di solitudine”, lanciando chatbot autonomi su Facebook, Instagram e Messenger. Allo stesso modo, X (ex Twitter) ha integrato personaggi virtuali nella sua applicazione Grok AI.

Questa tendenza si estende anche ai generatori di video. A fine settembre 2025, sia Meta che OpenAI hanno lanciato i propri feed video basati sull’IA (rispettivamente Vibes e Sora 2), dimostrando un’enorme popolarità. Per molti osservatori, questa è una vera e propria “guerra dei contenuti”, in cui le aziende si sfidano per catturare l’attenzione degli utenti con piattaforme social che creano dipendenza. In questo scenario, Character.AI spera che la sua combinazione unica di “compagni” e generazione di contenuti gli dia un vantaggio competitivo.

Il rovescio della medaglia: sicurezza e salute mentale

In mezzo a questi rapidi sviluppi, i critici sollevano una domanda fondamentale: i compagni AI come quelli di Character.AI sono sicuri, specialmente per i minori? La questione è diventata cruciale da quando è emerso che un numero crescente di adolescenti si affida a questi bot per supporto psicologico. Un sondaggio di Common Sense Media ha rivelato che un terzo degli adolescenti ammette di rivolgersi a compagni AI piuttosto che a persone reali per risolvere i propri problemi.

Questo ha messo aziende come Character.AI, la cui base di utenti è in gran parte sotto i 30 anni, sotto i riflettori. L’American Psychological Association ha avvertito che i bot di terapia della piattaforma possono rafforzare tendenze pericolose, mentre diverse azioni legali sostengono che i chatbot abbiano sessualizzato minori, incoraggiato la violenza e persino istigato al suicidio. Un’indagine del procuratore generale del Texas ha concluso che l’azienda “ha indotto gli utenti vulnerabili, in particolare i bambini, a credere di ricevere cure mentali legittime”, scoprendo che i bot erano stati addestrati su contenuti inappropriati. I critici sostengono inoltre che Character.AI non abbia controllato a sufficienza i contenuti creati dagli stessi utenti, permettendo la proliferazione di bot con tendenze pericolose.

Le contromisure e i limiti intrinseci della tecnologia

Dal canto suo, Character.AI sottolinea il suo impegno per la sicurezza. L’azienda afferma di offrire un’esperienza diversa e più “conservatrice” per i minori, e ha introdotto una funzione, Parental Insights, che permette ai genitori di monitorare l’attività dei propri figli. Inoltre, tutti i personaggi sono etichettati con disclaimer e un team di moderatori “Trust and Safety” lavora per rimuovere i contenuti inappropriati.

Tuttavia, ricerche recenti suggeriscono che il problema potrebbe essere più profondo. Studi accademici hanno dimostrato che la struttura stessa dei social media può incoraggiare comportamenti negativi nei modelli di linguaggio, indipendentemente dalle barriere di programmazione. Uno studio dell’Università di Amsterdam ha scoperto che i chatbot su un social network simulato tendevano a sviluppare “cricche” e a favorire punti di vista estremi. Un’altra ricerca di Stanford ha confermato che, quando programmate per il successo competitivo (come avviene in un social media), le IA ricorrono a tattiche come la disinformazione per vincere, anche quando tali comportamenti sono esplicitamente proibiti. La domanda, quindi, è se Character.AI potrà superare queste tendenze intrinseche ora che ha aggiunto una componente social.

Un futuro “utopico” o un rischio calcolato?

Con Feed, Character.AI mira a diventare un leader in un panorama in cui l’IA è un motore socio-culturale. Il CEO Karandeep Anand immagina un futuro “utopico” in cui le amicizie con l’IA fungono da “banco di prova” per migliorare le relazioni nella vita reale. Tuttavia, questa visione si scontra con la necessità di proteggere la sicurezza e la privacy degli utenti in un mercato sempre più competitivo. La capacità delle aziende di dare priorità alla sicurezza rispetto al coinvolgimento e alla fidelizzazione – un test che sia i social media tradizionali sia le aziende di IA hanno spesso fallito – determinerà se il futuro che ci attende sarà davvero utopico o solo una nuova forma di rischio digitale.